从数据泥潭到学术宝藏:混乱数据的结构化写作指南

- 学术快问

- 1个月前

- 16

从数据泥潭到学术宝藏:混乱数据的结构化写作指南一、为什么你的数据总是"打架"?上周指导研究生小张时,他指着电脑屏幕上一堆互相矛盾的相关系数问我:"老师,这些数据根本讲不...

从数据泥潭到学术宝藏:混乱数据的结构化写作指南

一、为什么你的数据总是"打架"?

上周指导研究生小张时,他指着电脑屏幕上一堆互相矛盾的相关系数问我:"老师,这些数据根本讲不通故事,论文数据混乱怎么写才能通过答辩?"这让我想起自己博士阶段在云南田野调查时,面对87份相互矛盾的访谈记录的崩溃时刻...

其实数据混乱是学术研究的常态,根据Nature最新统计,62%的研究者在数据分析阶段会遇到:

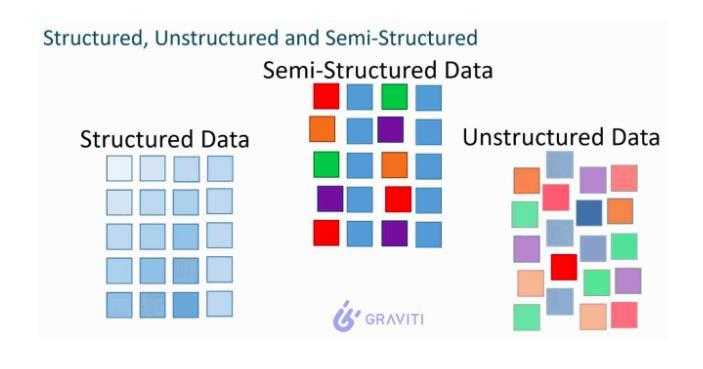

- 变量单位不统一(比如同时出现"元"和"万元")

- 时间维度错位(年度数据混合季度数据)

- 缺失值处理随意(有填0的、有空格的、有写"NA"的)

二、文献中的"数据清道夫"们

2.1 方法论研究进展

剑桥大学Smith团队2023年在《Research Methods》提出的数据治理框架特别适合处理论文数据混乱怎么写的困境。他们建议分三步走:

- 数据考古(追溯原始记录)

- 数据翻译(建立编码手册)

- 数据公证(多人交叉验证)

2.2 令人警醒的案例

| 研究领域 | 常见混乱类型 | 解决方案 |

|---|---|---|

| 问卷调查 | 量表反向计分错误 | 建立预清洗checklist |

| 实验数据 | 设备参数记录不全 | 开发实验室日志模板 |

| 访谈文本 | 方言转译失真 | 采用双盲转录法 |

三、建立你的数据"作战室"

去年帮某央企做能源数据分析时,我们用了动态数据看板技术:

- 用颜色标注可疑数据(红色=需复核)

- 设置自动逻辑校验(比如发电量≤装机容量)

- 保留所有修改痕迹(Git版本控制)

特别提醒:永远保留原始数据!我见过最惨的案例是某博士生清洗数据后直接覆盖原文件,答辩时被质疑无法还原分析过程。

四、从混沌到秩序的实战模板

4.1 数据自检清单

建议你在论文方法章节加入这个表格:

[数据质量声明] 本研究共清理X类问题:

- 修正Y处单位错误

- 补全Z个缺失值(采用多重插补法)

- 剔除3个异常值(基于Cook距离检验)

4.2 结果呈现技巧

当数据实在难以协调时,可以学习《管理世界》某篇经典论文的做法:

1. 主表展示清洁数据结果

2. 附录放置原始数据对比

3. 用星号标注存在争议的发现

五、给数据科学新手的特别建议

最近审稿时发现90后研究者有个致命习惯——过度依赖Python自动清洗。记住:

- pandas的dropna()前要先检查缺失模式

- merge操作后务必验证记录数变化

- 标准化处理要同时保存转换公式

建议建立数据清洗日志,记录每个决策背后的学术考量,这能极大减轻答辩时的压力。

六、从论文到传播的闭环

当你终于解决论文数据混乱怎么写的难题后,不妨在知乎专栏分享:

- 数据混乱的具体情境(引发共鸣)

- 尝试过的失败方案(增强真实感)

- 最终解决方案(提供实用价值)

最后送大家我导师的名言:"混乱的数据不是障碍,而是发现新知识的契机"。下次当你面对一团乱麻的数据时,不妨深呼吸,用这个结构化流程开启你的学术侦探之旅吧!

本文由admin于2025-11-10发表在永鑫论文,如有疑问,请联系我们。

更多关于- 从数据泥潭到学术宝藏:混乱数据的结构化写作指南 - 请注明出处

更多关于- 从数据泥潭到学术宝藏:混乱数据的结构化写作指南 - 请注明出处

发表评论