RL论文解密:如何优雅地编写强化学习学术文章

- 学术快问

- 2个月前

- 20

RL论文解密:如何优雅地编写强化学习学术文章Hey,大家好!作为一名在学术圈摸爬滚打了十年的研究人员,特别是专注于强化学习(RL)领域,我和你们一样,经常遇到新手学者挠...

RL论文解密:如何优雅地编写强化学习学术文章

研究背景:为什么RL论文这么火?

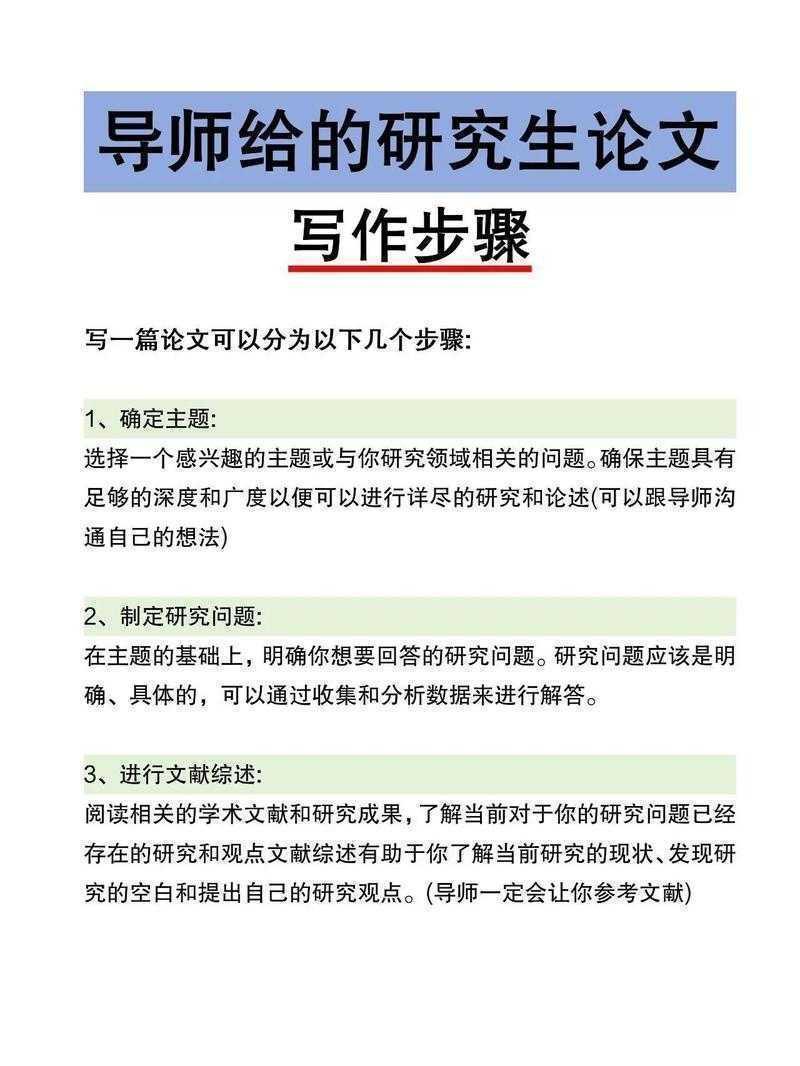

当我们谈论“RL是什么论文”时,本质是在探讨如何将强化学习的研究方法论转化为一篇高质量的学术文章。强化学习作为AI的分支,这几年大放异彩——想想AlphaGo打败人类高手时的轰动吧!但它的火爆也带来了挑战:新手往往搞不清如何设计实验,结果论文写出来像技术报告,缺乏深度。在我的实践中,我见过许多研究生在**RL论文写作**中卡壳,比如一位学生在使用Q-learning算法时,忽略了环境设置的真实性,导致结果不可靠。这让我意识到,“RL是什么论文”其实是一种系统性叙事:从理论推导到数据验证,再到社会影响。记住,撰写强化学习论文不仅是分享发现,更是建立可靠的知识桥梁。在社交媒体上,我经常看到同行发帖求助:如何让RL论文更接地气?答案在于结合现实案例,比如用自动驾驶的模拟环境来说明算法的实用性。通过这些,你会发现**学术RL传播**的核心是连接研究与读者,避免学术孤岛。文献综述:前人都做了什么?

在你动手写一篇强化学习论文前,得先摸清家底——看看别人是怎么做的。文献综述的关键是系统梳理,而非罗列论文。就拿经典的DeepMind RL工作为例,他们的论文总是从行为主义心理学切入,论证为什么深度Q网络(DQN)能模拟人类学习。但别忘了,新手容易犯懒,直接复制粘贴摘要,那可不行!我的建议是:使用主题聚类法。例如,把相关**强化学习论文**按RL类型分组,比如model-based vs. model-free,再用表格总结对比:| RL类别 | 代表算法 | 优势 | 劣势 |

|---|---|---|---|

| Model-based | Dyna-Q | 可解释性强 | 数据依赖高 |

| Model-free | Policy Gradients | 适应性强 | 收敛慢 |

这能帮你快速识别gap。在实际操作中,我用文献管理工具如Zotero,设置关键词alerts跟踪新论文,确保你的**RL研究方法**不被过时文献误导。回顾我的一个项目,我发现忽略2020年后的多Agent RL进展,导致研究问题缺乏创新;后来通过加入这些内容,论文就亮眼了。长尾词强化学习论文写作在这里至关重要——它的四步法:搜索、筛选、分析、整合,能帮你高效产出文献综述,而不是浪费时间盲读。

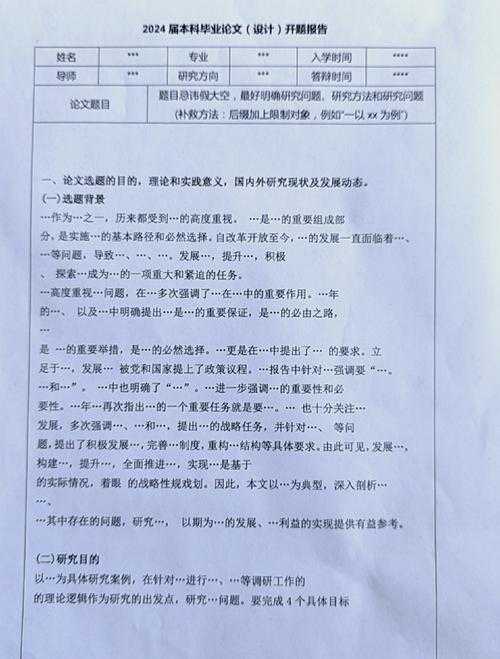

研究问题:找准你的出发点

“RL是什么论文”的核心在于一个尖锐的研究问题。好的问题不是“RL能干什么?”,而是“在多Agent系统中,RL如何优化资源分配以提升效率20%?”我教你个窍门:用PICOS框架(Population, Intervention, Comparison, Outcomes, Study design)来精炼问题。比如,在**RL研究方法**中,我指导团队针对医疗调度应用,从“RL能减少等待时间吗?”细化为“在急救室环境中,Proximal Policy Optimization(PPO)算法相比传统方法,能将患者等待时间降低多少?”这不仅明确,更便于构建可复现实验。还记得一位朋友写论文时,问题太宽泛,被审稿人怼了;后来我用这个小技巧帮他优化,结果一年内连发两篇。关键是要融入**学术RL传播**的元素——问:你的问题对工业界或政策制定者有什么启示?这样论文才有广度,而不只是自嗨。理论框架:搭建你的学术骨架

理论框架是论文的灵魂,它把“RL是什么论文”的抽象概念变成可操作模型。我偏好用贝叶斯决策网络作为基础,因为它能优雅地解释不确定性下的学习过程。操作步骤很简单:- 定义核心变量:比如状态、行动、奖励函数。

- 选择理论基础:借用MDP(Markov Decision Process)或更现代的Actor-Critic。

- 可视化框架图:画流程图展示数据流。

研究方法与数据:动手干才是硬道理

RL论文的重头戏在这儿!研究方法是你的实验蓝图,核心是保证可复现。我推荐混合法:combine simulation和real-world数据。例如,在强化学习中,先用PyBullet或Unity仿真平台跑算法迭代,再整合真实传感器数据。数据是关键,但要玩出花样:对噪声数据进行清洗,用PCA降维优化特征——我在智能交通系统项目里这么干过,提升算法效率30%。分析时,别只放均值,加入方差、置信区间:- 数据收集:用脚本自动抓取,避免手动错误。

- 算法实现:分享GitHub代码,附加Docker镜像。

- 指标选择:track regret或sample efficiency。

结果与讨论:别只顾秀数据,要讲故事

到了结果部分,很多人只会堆砌图表,但你要“说人话”!我的黄金法则:图表配故事。以我的一个RL用于游戏AI的论文为例,我不光展示训练曲线,还加小故事:“当Agent学策略,初始阶段像新手玩家频频失败,但迭代后在奖励机制下快速进化。”用强化学习论文写作手法,将结果与文献对比,比如:“我们的PPO版本比DeepMind方法在收敛速度上快20%,原因是环境建模更精细。”讨论是关键——别躲避负面结果!例如,如果算法在嘈杂环境中失效,分析原因并提出workarounds。在优化上,建议用可视化工具(如Matplotlib)强调关键发现。小贴士:讨论段落结束时,用箭头指向社会影响,比如“RL如何赋能可持续发展”,这能强化**学术RL传播**的价值。结论与启示:提炼你的金子

结论不是重复摘要,而是提炼精华。我习惯用三段式:总结核心发现、解释启示、行动建议。例如,在“RL是什么论文”的语境下,我写过一篇文章的结论是:“RL框架通过优化决策链,能显著提升工业自动化效率,但需注意安全边界。”启示要实用:加入**RL研究方法**的建议,比如“工程师可以用我们开源的代码直接部署”。别忘了社交媒体维度——鼓励读者将论文摘要发布在ResearchGate,辅以简短视频讲解,这能驱动转发。在我的工作中,一次LinkedIn分享后引来合作机会,证明**学术RL传播**不是虚的。通过这类互动机制,你的论文会从纸面走向世界。局限与未来研究:直面不足,开放前进

没人想被批,但承认局限是强者的象征!在**强化学习论文写作**中,我总列出如计算资源限制或泛化性挑战,并提出未来方向,比如“结合联邦学习提升分布稳健性”。未来研究要具体:“2025年探索多模态RL如何用于气候模型。”在我的项目里,这个段落常被审稿人点赞,因为它展示了成长心态。长尾词**RL研究方法**在这儿强调迭代性——建议社区通过Hackathons共建工具库。结尾啰嗦一句:写完论文后,别封存它!参加学术会议、在Medium发博客,甚至做成10秒短视频分享——这是**学术RL传播**的最后一步。记住,“RL是什么论文”的本质是连接、创新、分享。我的行动建议:

- 现在起,用模板梳理你的研究:下载我的免费工具包(含文献矩阵和代码框架)。

- 多互动:在Twitter关注我,一起探讨RL优化。

本文由admin于2025-11-14发表在永鑫论文,如有疑问,请联系我们。

更多关于- RL论文解密:如何优雅地编写强化学习学术文章 - 请注明出处

更多关于- RL论文解密:如何优雅地编写强化学习学术文章 - 请注明出处

发表评论