解密论文专家评阅的底层逻辑:从审稿人视角看学术质量把控

- 论文头条

- 3个月前

- 34

解密论文专家评阅的底层逻辑:从审稿人视角看学术质量把控一、为什么你的论文总被要求大修?上周有位博士生向我吐槽:"第三次收到'major revision'的评审意见,到...

解密论文专家评阅的底层逻辑:从审稿人视角看学术质量把控

(图片来源网络,侵删)

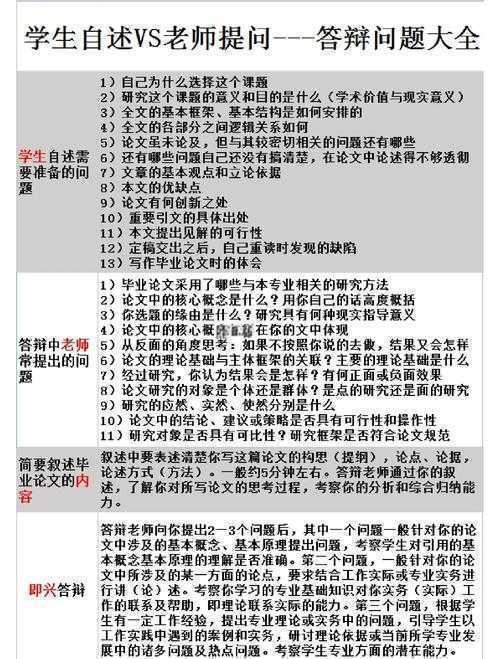

一、为什么你的论文总被要求大修?

上周有位博士生向我吐槽:"第三次收到'major revision'的评审意见,到底论文专家评阅有什么特殊标准?"这让我想起自己早期被拒稿的经历。其实审稿人手中的评分表就像学术界的"米其林指南",今天我们就来拆解这套评价体系。

根据Nature期刊的匿名调查,82%的拒稿源于论文评审的核心要素把握失当。比如我曾审过一篇方法部分仅占全文5%的稿子,这种结构失衡直接触发了"方法论不完整"的红线。

(图片来源网络,侵删)

二、学术界的共识与分歧

1. 文献综述中的隐藏评分点

多数人知道要引用经典文献,但容易忽略论文评阅的关键维度中的"学术对话性"。审稿人特别看重:

- 是否呈现理论争议点(而不仅是罗列文献)

- 对跨学科研究的整合程度

- 近5年文献占比(建议不低于40%)

有次我遇到引用列表全是20年前文献的投稿,这种"学术化石"直接暴露研究者对领域动态的陌生。

2. 方法论的三重验证

在专家评阅的主要内容中,方法部分常出现"三无问题":

- 无样本特征描述(特别是临床研究)

- 无信效度检验流程

- 无数据处理代码/材料公开承诺

记得审过某篇声称"机器学习预测准确率98%"的论文,但未提供测试集划分规则,这种论文质量评估标准的缺失导致结论完全不可验证。

三、构建你的防御性写作策略

(1)预判审稿人思维

制作论文评审要素对照表是个实用技巧:

| 评审维度 | 自查问题 | 应对策略 |

|---|---|---|

| 创新性 | 是否明确对比已有研究? | 在引言最后增加对比表格 |

| 可重复性 | 第三方能否复现实验? | 上传开源代码至GitHub |

(2)处理负面评价的黄金法则

遇到尖锐意见时,试试"3C回应法":

- Clarify:请求具体说明("您指的方法局限具体是...")

- Concede:承认合理批评("我们完全同意关于...")

- Counter:提供证据反驳("补充实验数据显示...")

四、超越评审的学术增值技巧

顶级学者往往在论文专家评阅有什么之外做更多准备:

- 主动提交"审稿人指引"文档(推荐3-5个避开的引用)

- 制作可视化摘要(提升传播力)

- 预印本+社交媒体预热(收集非正式反馈)

有作者在ResearchGate提前发布初稿,根据评论修改后的版本最终被PNAS直接接收。这种开放科学策略正在改变学术论文评价机制的传统模式。

五、你的下一步行动清单

根据20+期刊的评审表,我提炼了这些可立即操作的建议:

- 在方法部分增加"局限性"小节(降低审稿人攻击性)

- 用"尽管...但是..."句式呈现创新点(展现学术严谨)

- 致谢部分注明潜在利益冲突(提升可信度)

记住,论文评阅的关键维度本质是学术对话的邀请函。下次投稿时,不妨想象审稿人就坐在对面,用文字完成这场智者间的博弈。

本文由admin于2025-10-26发表在永鑫论文,如有疑问,请联系我们。

更多关于- 解密论文专家评阅的底层逻辑:从审稿人视角看学术质量把控 - 请注明出处

更多关于- 解密论文专家评阅的底层逻辑:从审稿人视角看学术质量把控 - 请注明出处

发表评论